Na quarta-feira, a Meta apresentou um modelo de IA denominado Segment Anything Model (SAM), capaz de identificar objetos individuais em imagens e vídeos, mesmo aqueles que não foram vistos durante o treinamento, conforme informa a Reuters.

Resumo em tópicos:

- Meta apresenta o modelo de IA Segment Anything Model (SAM).

- SAM identifica objetos individuais em imagens e vídeos, mesmo sem vê-los durante o treinamento.

- Tecnologia de segmentação de imagem visa facilitar análise e processamento de imagens.

- Aplicações possíveis: compreensão de conteúdo na Web, realidade aumentada, edição de imagens e auxílio em estudos científicos.

- Meta busca democratizar o processo de criação de modelos de segmentação, incentivando pesquisas em visão computacional.

- Conjunto de dados “SA-1B” inclui 11 milhões de imagens e 1,1 bilhão de máscaras de segmentação.

- SAM e conjunto de dados serão disponibilizados sob licença Apache 2.0.

- Demonstração interativa gratuita da tecnologia de segmentação disponível no GitHub.

- SAM se destaca pela identificação de objetos não presentes em seu conjunto de dados de treinamento e abordagem parcialmente aberta.

- Modelo de linguagem LLaMA da Meta já inspira projetos derivados.

- Competição acirrada entre gigantes da tecnologia no campo da IA, como ChatGPT da OpenAI apoiado pela Microsoft.

Na quarta-feira, a Meta apresentou um modelo de IA denominado Segment Anything Model (SAM), capaz de identificar objetos individuais em imagens e vídeos, mesmo aqueles que não foram vistos durante o treinamento, conforme informa a Reuters.

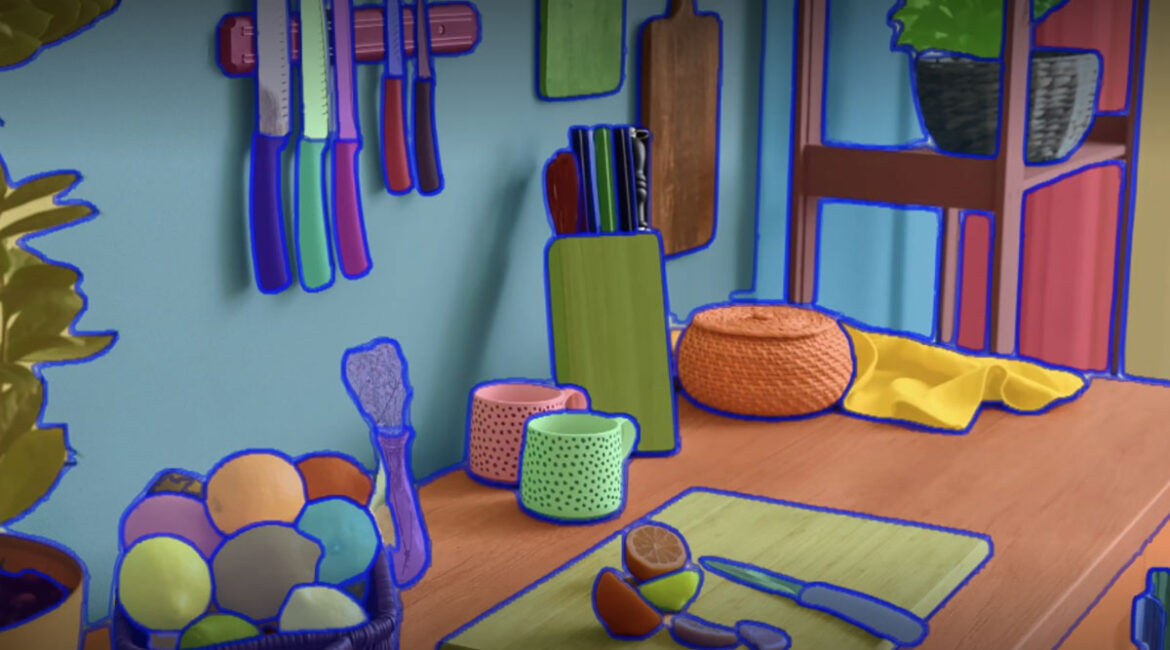

Conforme uma publicação no blog da Meta, o SAM é um modelo de segmentação de imagem que responde a solicitações de texto ou cliques do usuário para isolar objetos específicos em uma imagem. A segmentação de imagem é uma técnica de visão computacional que consiste em dividir uma imagem em diversos segmentos ou regiões, cada um representando um objeto ou área de interesse específico.

O propósito da segmentação de imagem é facilitar a análise ou processamento de uma imagem. A Meta acredita que essa tecnologia pode ser útil para compreender o conteúdo de páginas da Web, aplicativos de realidade aumentada, edição de imagens e auxílio em estudos científicos, localizando automaticamente animais ou objetos a serem rastreados em vídeos.

A Meta afirma que, geralmente, a criação de um modelo de segmentação preciso “exige trabalho altamente especializado de técnicos especialistas com acesso à infraestrutura de treinamento de IA e grandes volumes de dados no domínio cuidadosamente anotados”. Com o SAM, a Meta pretende “democratizar” esse processo, diminuindo a necessidade de treinamento especializado e expertise, o que espera incentivar mais pesquisas em visão computacional.

Adicionalmente, a Meta criou um conjunto de dados chamado “SA-1B”, que inclui 11 milhões de imagens licenciadas de “uma grande empresa de fotografia” e 1,1 bilhão de máscaras de segmentação geradas pelo seu modelo de segmentação. A Meta disponibilizará o SAM e seu conjunto de dados para pesquisa sob uma licença Apache 2.0.

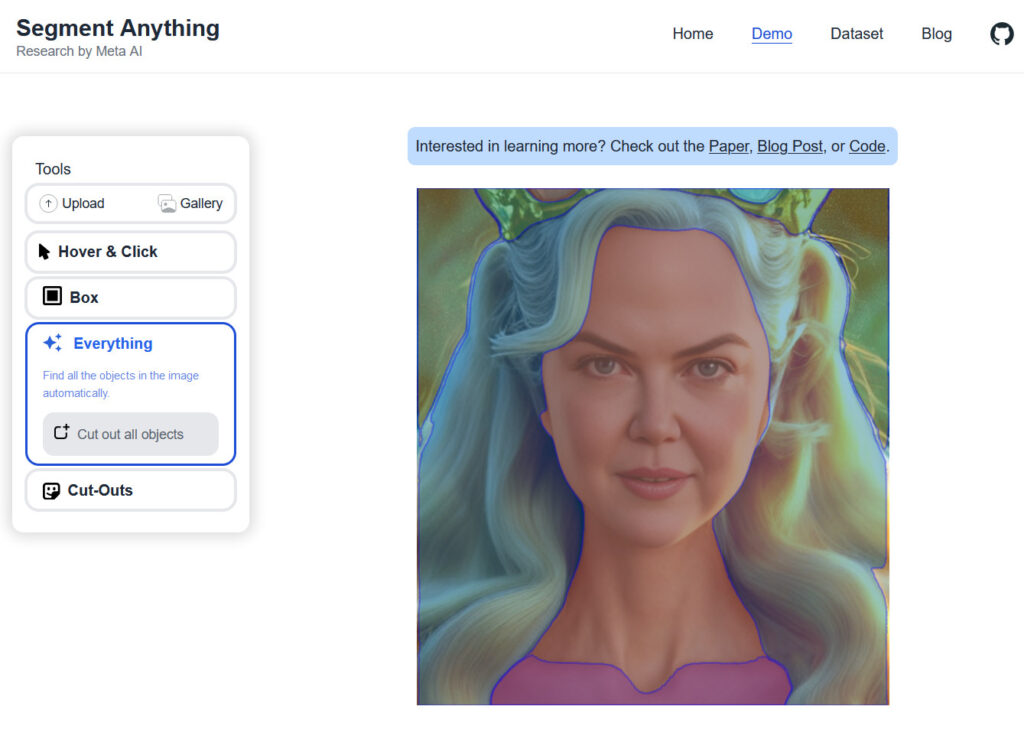

Atualmente, o código (sem os pesos) está disponível no GitHub, e a Meta desenvolveu uma demonstração interativa gratuita de sua tecnologia de segmentação. Nessa demonstração, os visitantes podem enviar uma foto e usar “Hover & Click” (selecionar objetos com o mouse), “Box” (selecionar objetos dentro de uma caixa de seleção) ou “Everything” (que tenta identificar todos os objetos na imagem automaticamente).

Embora a tecnologia de segmentação de imagem já exista há algum tempo, o SAM se destaca por sua capacidade de reconhecer objetos não presentes em seu conjunto de dados de treinamento e por sua abordagem parcialmente aberta. Além disso, o lançamento do conjunto de dados SA-1B pode impulsionar uma nova geração de aplicativos de visão computacional, de forma semelhante ao modelo de linguagem LLaMA da Meta, que já inspira projetos derivados.

Segundo a Reuters, Mark Zuckerberg, CEO da Meta, destacou a importância de integrar IA generativa nos aplicativos da empresa neste ano. Apesar de a Meta ainda não ter lançado um produto comercial utilizando esse tipo de IA, já empregou previamente uma tecnologia semelhante ao SAM internamente no Facebook para marcação de fotos, moderação de conteúdo e determinação de postagens recomendadas no Facebook e Instagram.

O anúncio da Meta surge em meio à crescente competição entre as gigantes da tecnologia para dominar o campo da IA. O modelo de linguagem ChatGPT da OpenAI, apoiado pela Microsoft, atraiu ampla atenção no outono de 2022, desencadeando uma onda de investimentos que pode estabelecer a próxima grande tendência de negócios em tecnologia, além das mídias sociais e smartphones.

Essa competição acirrada indica que o campo da IA está em constante evolução e expansão, com empresas buscando liderar o desenvolvimento de novas soluções e aplicativos. A medida em que a IA generativa avança e se torna mais acessível, é provável que vejamos um aumento no número de inovações, melhorando a eficiência e a experiência do usuário em várias indústrias e aplicativos.

Em resumo, a introdução do Segment Anything Model (SAM) pela Meta é um passo significativo no desenvolvimento de tecnologias de segmentação de imagem e visão computacional. A capacidade do SAM de identificar objetos não vistos durante o treinamento e sua abordagem parcialmente aberta podem levar a uma nova geração de aplicativos de visão computacional e pesquisas inovadoras. Além disso, a competição no campo da IA entre as grandes empresas de tecnologia pode impulsionar ainda mais o avanço e a adoção dessa tecnologia em diversos setores.

Fonte: arstechnica.com